소개

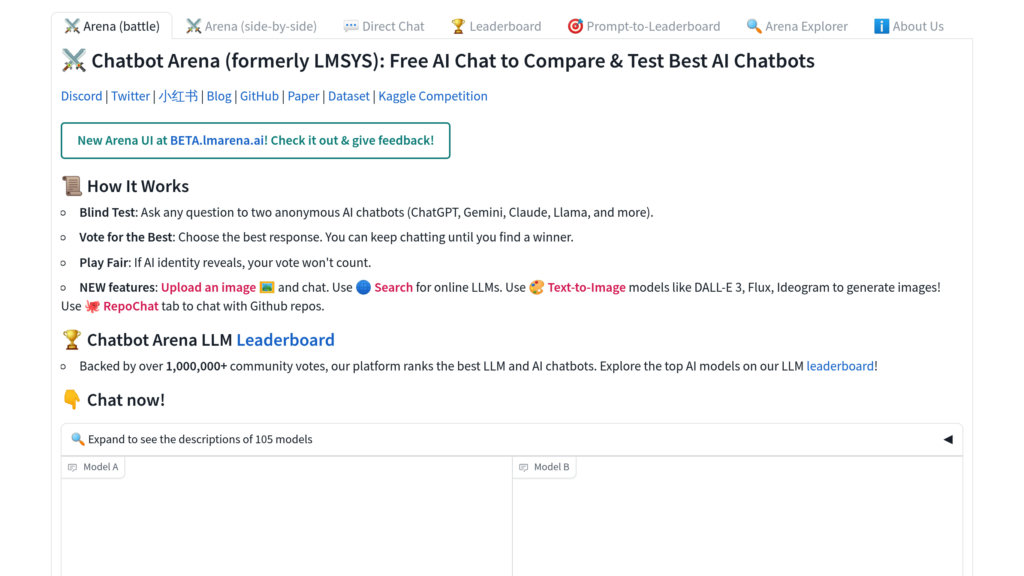

LM Arena(챗봇 아레나)는 LMSYS와 UC Berkeley SkyLab이 공동 개발한 커뮤니티 주도 오픈소스 플랫폼으로, 대형 언어 모델의 성능을 실시간으로 평가하고 순위를 매깁니다.

주요 기능

• 사용자 참여형 모델 비교: 익명으로 진행되는 두 LLM의 대결에서 사용자가 더 우수한 응답을 선택하며 신뢰성 높은 평가 데이터를 구축합니다

• Elo 점수 기반 순위 시스템: 체스 등에서 사용되는 검증된 Elo 레이팅을 적용하여 모델 성능을 동적이고 통계적으로 평가합니다

• 완전한 오픈소스 구조: 프론트엔드부터 백엔드, 평가 알고리즘에 이르기까지 모든 플랫폼 구성 요소가 공개되어 있습니다

• 실시간 성능 평가: 실제 사용자 프롬프트와 투표를 기반으로 한 지속적인 벤치마킹으로 최신 모델 성능을 반영합니다

• 다양한 모델 지원: 오픈소스 모델부터 상업용 API까지 폭넓게 지원하며 평가의 투명성과 재현성을 보장합니다

• 커뮤니티 협력 강화: 사용자 참여를 장려하고 모든 평가 데이터를 공개하여 협력적 AI 연구 환경을 조성합니다

주요 활용 분야

• LLM 성능 비교 분석: 연구자와 개발자가 실제 사용 환경에서 다양한 언어 모델의 효과성을 체계적으로 비교할 수 있습니다

• 애플리케이션 맞춤형 모델 선정: 기업과 조직이 커뮤니티 기반 실시간 순위를 참고하여 특정 용도에 최적의 LLM을 선택할 수 있습니다

• 공개 과학 연구 지원: 학계와 AI 전문가들이 공유 데이터와 도구를 활용하여 재현 가능한 연구를 진행하고 모델 발전에 기여할 수 있습니다

• 모델 개선을 위한 피드백 수집: AI 개발자가 실제 사용자의 익명 평가 데이터를 통해 출시 전 모델 성능을 향상시킬 수 있습니다