소개

Cerebras이란 무엇인가요?

Cerebras는 세계 최대 반도체 칩인 Wafer-Scale Engine(WSE)과 대표 시스템 CS-3를 기반으로 한 혁신적인 AI 컴퓨팅 플랫폼입니다.

AI 작업을 위해 설계된 Cerebras는 대형 언어 모델 및 생성형 AI의 학습과 추론에서 탁월한 성능을 제공하며, 온프레미스와 클라우드 모두에서 사용할 수 있습니다.

독특한 웨이퍼 스케일 아키텍처로 원활한 확장성, 손쉬운 배포, 업계 최고 속도를 실현하여 AI 혁신을 추구하는 조직의 최적 솔루션이 됩니다.

주요 기능

Wafer-Scale Engine (WSE)

세계 최대 AI 프로세서를 활용하여 대규모 AI 작업을 위한 전례 없는 메모리 대역폭과 연산 성능을 제공합니다.

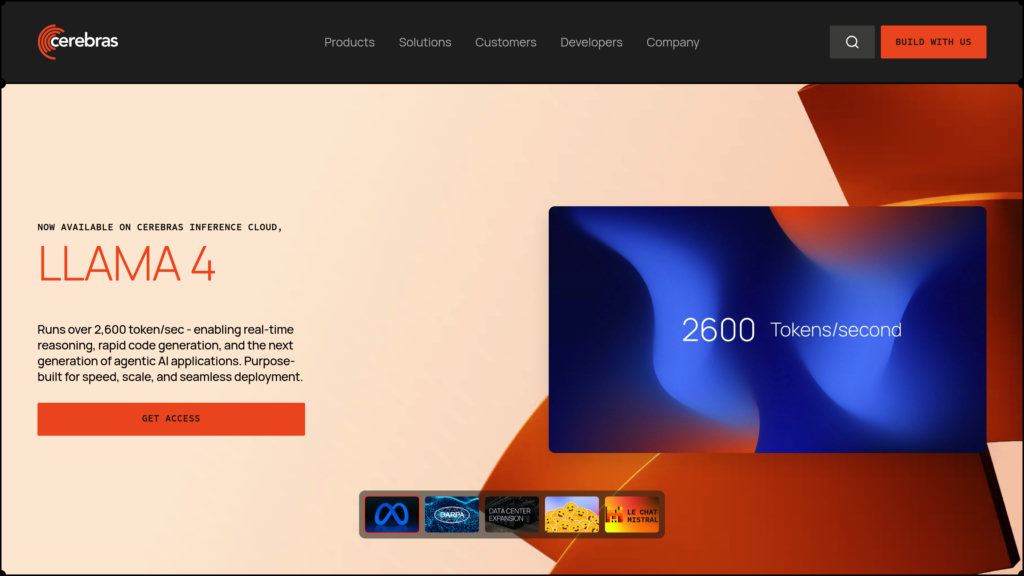

Industry-Leading Speed

GPU 기반 솔루션 대비 최대 20배 빠른 추론 및 학습 속도를 제공하며, 실시간 LLM 애플리케이션과 에이전트형 AI(Agentic AI)를 지원합니다.

Scalable Supercomputing

CS-3 시스템은 손쉽게 클러스터링되어 AI 슈퍼컴퓨터를 구성하며, 수십억~수조 파라미터 모델을 간편하게 배포할 수 있습니다.

Cloud and On-Premises Flexibility

즉시 접근 가능한 클라우드 서비스와 전용 인프라가 필요한 조직을 위한 온프레미스 하드웨어 모두로 제공됩니다.

16-bit Precision for Accuracy

16비트 가중치로 모델을 실행하여 최신의 정확도를 유지하며, 저정밀 추론의 타협 없이 성능을 보장합니다.

Custom AI Model Services

전문가의 안내로 모델 개발, 파인튜닝, 조직 역량 강화 서비스를 제공하여 기업의 AI 도입을 가속화합니다.

사용 사례

Large Language Model Training : 대규모 LLM 학습을 가속화하여 수주 걸리던 시간을 수일로 단축하고, 연구 및 제품 개발을 위한 반복 실험을 용이하게 합니다.

Real-Time AI Inference : 챗봇, 코드 생성, 에이전트형 AI(Agentic AI) 워크플로우 등 애플리케이션을 위한 즉각적이고 고처리량의 추론을 제공합니다.

Scientific Research : 생명과학, 헬스케어, 유전체학 분야에서 AI 모델의 신속한 학습 및 배포를 지원하여 신약 개발과 환자 치료 혁신을 촉진합니다.

Financial Services : 금융 분야에서 사기 탐지, 알고리즘 트레이딩, 대규모 문서 분석을 위한 빠르고 정확한 AI를 지원합니다.

Enterprise AI Deployment : 독자적 모델 구축이나 오픈소스 솔루션 배포를 위한 확장 가능하고 비용 효율적인 AI 인프라를 제공합니다.