紹介

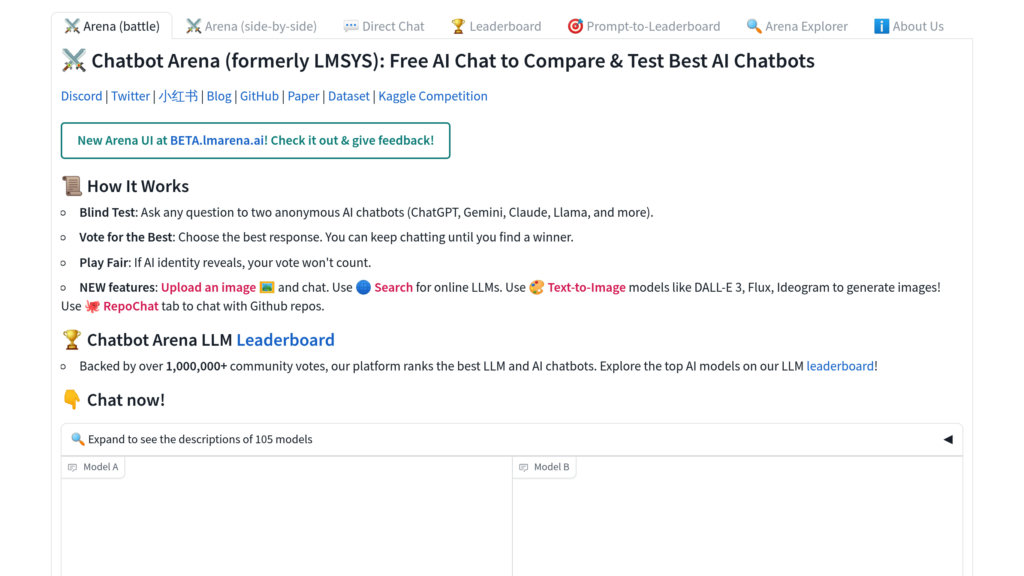

LM Arena(Chatbot Arena)は、LMSYSとUC Berkeley SkyLabが共同で開発したオープンソースのプラットフォームです。大規模言語モデル(LLM)の進化と理解を深めるため、ライブで透明性の高い、コミュニティ主体の評価環境を構築しています。ユーザーは匿名で2つのLLMの応答を比較し、投票を通じてモデルのパフォーマンスを評価。このデータを基に、Eloレーティングシステムを用いて動的なランキングを生成します。プラットフォームはオープンウェイトモデルから商用APIまで幅広くサポートし、実際のユーザープロンプトと選好に基づいた最新のベンチマークを実現します。すべてのインフラはGitHubで公開され、透明性と再現性を重視したオープンサイエンスを推進しています。

主な機能

- **コミュニティ投票によるモデル比較**: ユーザーが匿名のバトルに参加し、2つのLLMの応答を直接比較して投票。信頼性の高い比較データをクラウドソーシングで生成します。

- **動的なEloレーティングランキング**: 広く認知されたEloシステムを採用し、LLMの性能を統計的に信頼できる形で順位付け。ランキングは常に更新されます。

- **完全なオープンソース公開**: フロントエンド、バックエンド、評価パイプライン、ランキングアルゴリズムなど、プラットフォームの全コンポーネントが公開されています。

- **リアルタイムの継続的評価**: ユーザーのプロンプトと投票をリアルタイムで収集・反映。実際の使用場面を捉えた、生きたベンチマークを提供します。

- **多様な公開モデルの対応**: オープンソースモデルやAPI経由のモデルなど、様々な形態のLLMを評価対象とし、公平な比較を実現。

- **協調的な研究環境**: 広範なコミュニティ参加を促進し、収集データを公開。透明性を保ちながら協調的なAI研究の発展を支えます。

ユースケース

- **LLM性能のベンチマーク**: 研究者や開発者が、実運用環境に近い条件で様々な大規模言語モデルの能力を評価・比較できます。

- **実用向けモデル選定**: 組織や開発チームが、コミュニティの生のフィードバックに基づくランキングを参考に、特定の用途に最適なLLMを選択する際の判断材料となります。

- **オープンサイエンスと研究開発**: 学術研究者やAI実務者が、公開されたデータセットや評価ツールを利用して、再現性の高い研究やモデル改良を進めることが可能です。

- **モデル改善のためのフィードバック収集**: AIモデルの提供者は、匿名化されたユーザーの投票データや選好を分析し、正式リリース前に製品の質を高めるための貴重な洞察を得られます。